原本的计划是由不同的人完成关于BlACK EYE的一些图文、音视频创作,以构建丰富、积极的世界。但一直进展缓慢。这篇文章将详细记录我从零开始利用AI创作BLACK EYE PLAY的过程。

midjourney

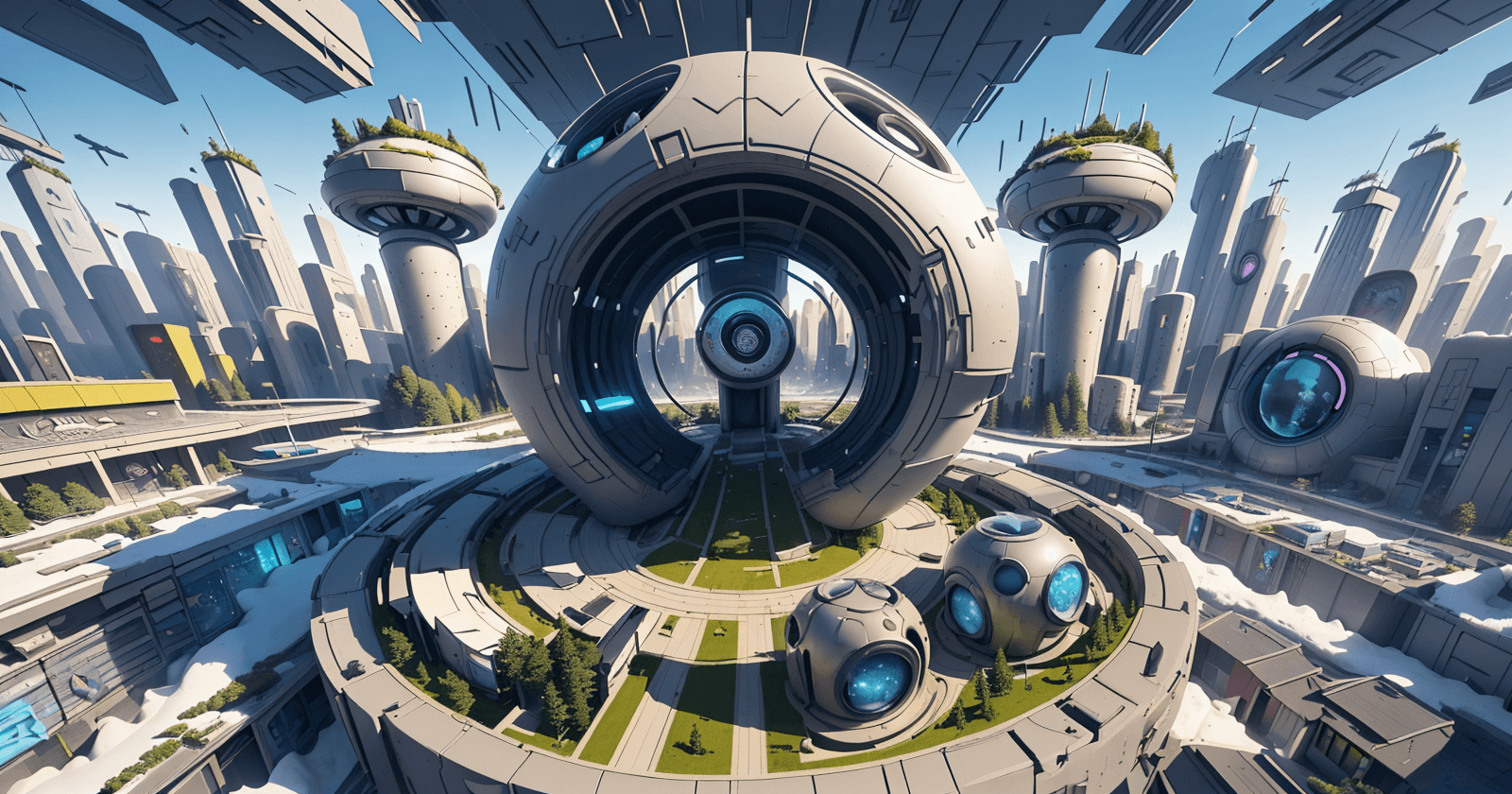

初期的时候,我尝试使用midjourney绘制了几张图,例如从冰雪中发现新世界的概念图、black eye play 中心广场的意向图:

从概念和想要表达的大致内涵来说,这些图都非常精彩可用。但是无论是从画风控制还是具体事物的表达上,我还没有很好地能力来控制midjourney。尤其是当我希望它生成一些角色的具体画面的时候,比如将EYE的形象给到midjourney,让它帮我生成更加细节丰富的画面,它常常会返回一个我完全不认识的角色。

我的问题

总结来说,我已经有了基本的形象设计,我希望以这个形象为主线穿插到未来的创作输出中来,而非抽卡式的随机图。

Sable Diffusion

于是我将目标转向Diffusion。

安装部署

经历了一番折腾,最终还是不得不拜倒于秋叶大大之下。

👉秋叶的B站主页。

👉想要百度网盘直接给up主私信关键词“整合包”。

用我六年前的1080台式机做初步的尝试。推荐刚过想接触的同学先从秋叶老师的整合包入手。可以帮助你先快速地尝试使用stable diffusion,以初步判断自己是否感兴趣或者该工具对解决你现有问题是否真的有效。而不至于在部署安装过程中消耗过多的时间和热情。

通过整合包的启动器打开stable diffusion的webui界面。随便输入一些文字点击生成感受一下sd文生图的过程。下民啊还有一堆内容选项我先没有理会。

社区

👉C站

我想的第一个问题:选择一个相对合适的模型。

我自己的做法是先看了一边秋叶老师的模型推荐。然后选用了橘子模型。(使用的采样方法推荐为:DPM ++ SDE Karras)根据示意的样图来看应该跟我们现有和未来的画面风格还有出入。不过可以先用来做一些简单的试玩和研究,更重要的是验证能否引入自己的角色进去。

秋叶老师的👉模型解析工具

怎么找模型👉找到合适的模型

直接从启动器进入webUI,不改变任何参数的情况下输入提示词“A cartoon character is at the counter processing documents, with a staff member sitting opposite him, illustration, 3D art, perfect light. Imitate the scenes from the movie Zootopia”

Midjourney生成的样图如下:

SD生成的样图如下:

切换橘子模型且不改变任何其它参数。

哈哈哈,好吧,似乎没有什么变化。所以说不定我可以在不安装任何其它模型的情况下验证我在这一步上面临的问题。但具体要怎么做呢?我的做法是先学习SD的基本使用。

入门SD的使用

👉B站第一套系统的AI绘画课!零基础学会Stable Diffusion

进行描述词优化

通过学习了解到出来的图片质量不高,首先是由提示词(Promopt)不够“具体”造成的。

尝试把提示词改为词组后,SD能够给我输出比较准确的画面内容。(调整迭代步数选择合适的采样方法。)但是画风还是跟想要的未来感差很多。我猜测还是模型的选择的问题。

在C站找了另外的模型测试(realCartoon3d),叠加style-DA,感觉离自己想要的方向又进了一步。

再次优化提示词。

出图参数

采样步数

模型参数迭代次数,默认20,理论上数值越大越精细。算力充足可以提高,但从20往后的边际收益越来越小。

采样方法

- Euler 插画风格,

- DPM 2M 和DPM Karras 出图速度较快

- SDE Karras 细节较丰富

实际使用时推荐用带有+号的。

以下我当前使用的版本没有的选看到的选项。

- 面部修复:建议勾选,识别人像并修复的算法,

- 平铺:创建拼接或平铺素材使用

- 高清修复:

- 提示词引导系数(CFG Scale):生成图和提示词的匹配度,一般不会浮动太多。(一般子啊7-12之间设置)

随机种子

找到合适的模型

发表回复